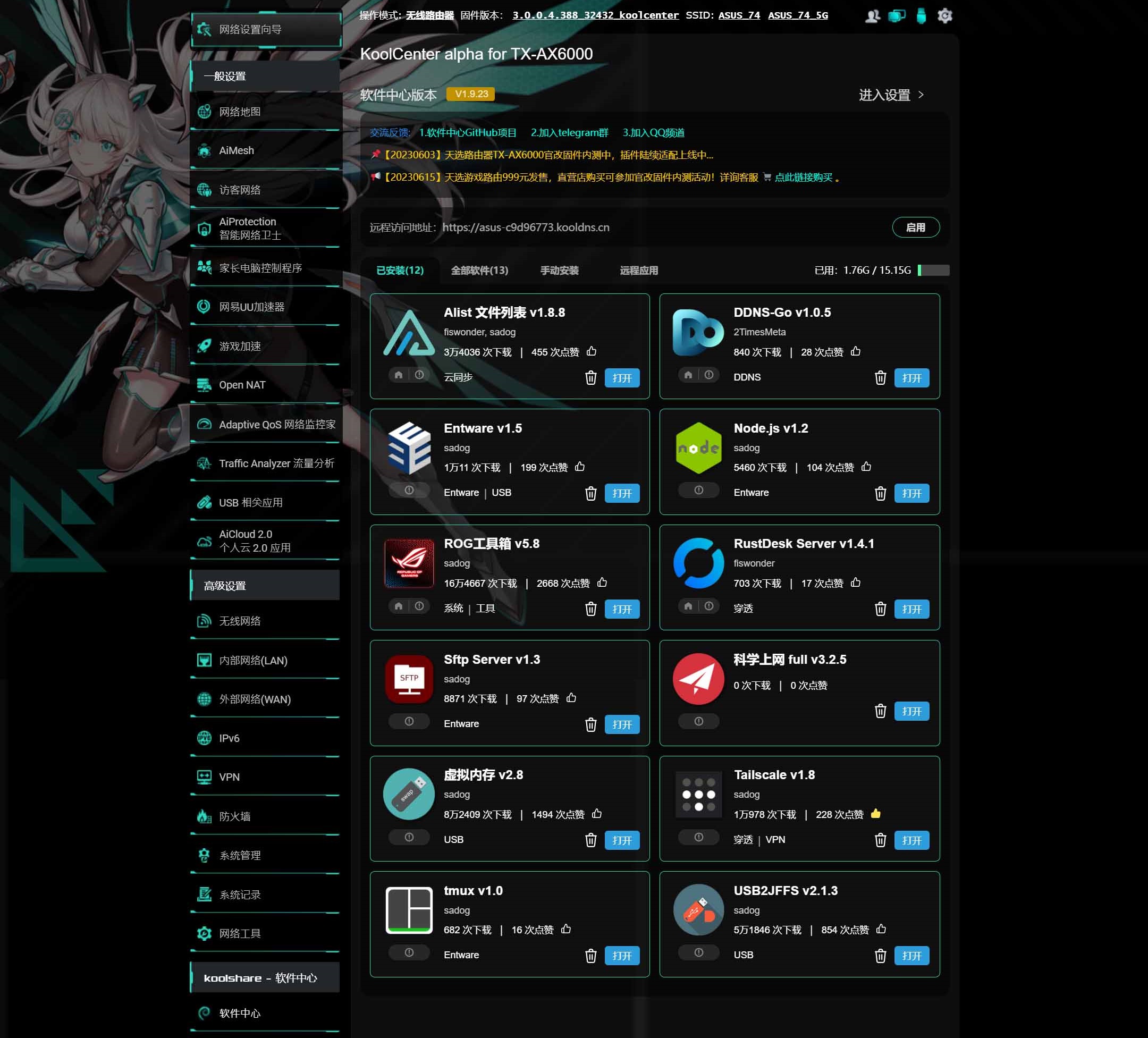

1.在 KoolCenter 固件中心下载对应型号的梅林改版固件:

https://fw.koolcenter.com

2.电脑连接路由器,点击左边的『系统管理』,选择『固件升级』- 点击上传,更新固件为梅林改版固件,进度条100%路由器会自行重启。

3.登录路由器,进行双清,手动配置路由器,完成后登录路由器,在『系统管理』–『系统设置』内勾选:Format JFFS partition at next boot 和 Enable JFFS custom scripts and configs, 点击『应用本页面设置』,成功后重启路由器,再次登录后出现『软件中心』。

4.下载安装科学插件,点击『软件中心』,软件中心版本,『进入设置』,点击『更新』保持当前版本与在线版本一致。点击 『手动安装』,选择已下载好的 MerlinClash插件文件。

merlinclash 插件使用文档与插件下载地址:

https://mcreadme.gitbook.io/mc

https://t.me/merlinclashfile

科学上网插件下载地址:

https://github.com/hq450/fancyss

使用 CM 修改的 Worker 脚本自动生成自适应订阅,SUB CLASH 和 SURGE 订阅地址,自动优选 IP。

Github 项目地址:

https://github.com/cmliu/edgetunnel

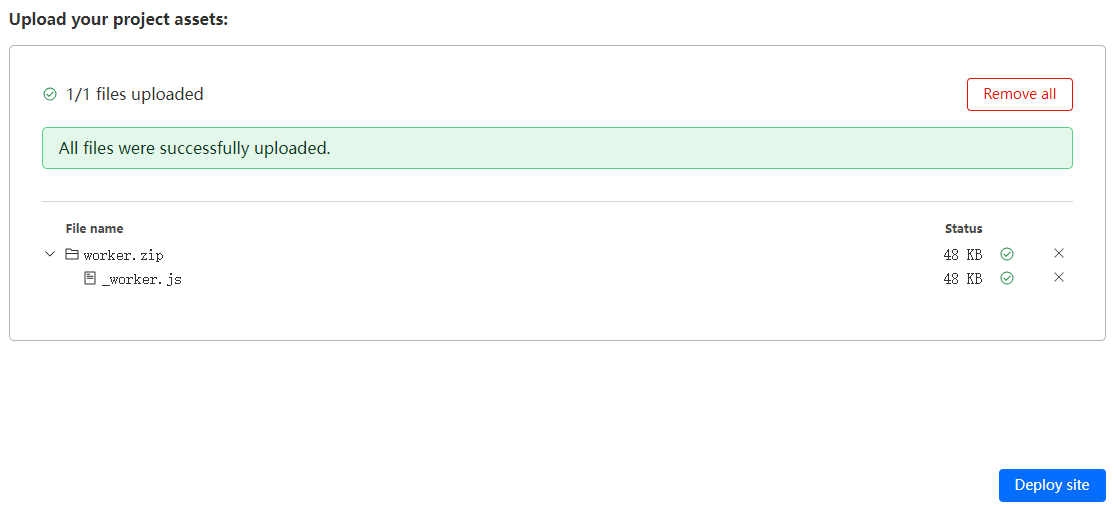

部署

1.登录 CloudFlare,点击 Workers 和 Pages,Pages ,直接上传创建 – 上传资产。

2.输入一个喜欢的项目名字,创建项目。

3.下载 worker.zip,然后在上传资产页面点击从计算机中选择 – 上传压缩文件,部署站点,继续处理项目。

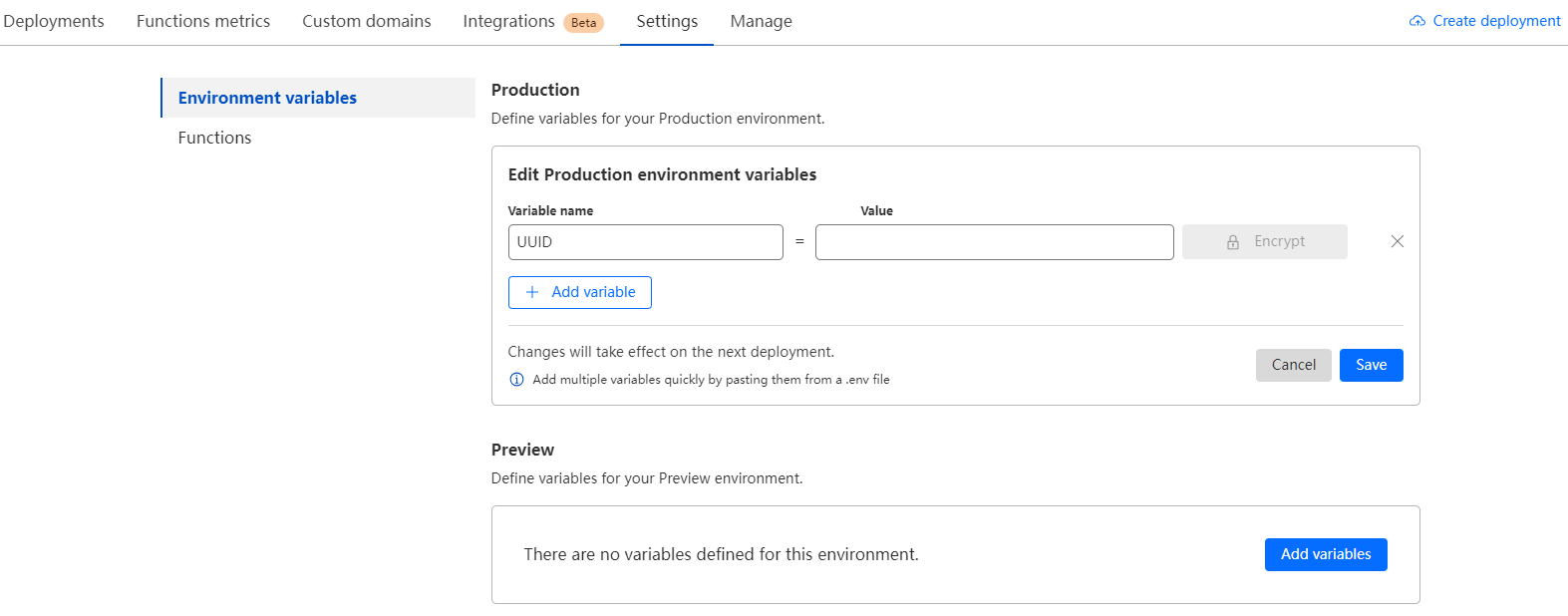

4.在 UUID 生成工具网站 https://nonni.cn/uuid 生成一个 UUID。

5.在项目页面点设置 – 环境变量 – 添加变量,变量名称为 UUID ,变量值为刚才生成的那个 UUID ,点击保存。

6.在项目页面点部署,创建新部署,再次上传刚才上传过的 worker.zip 文件,保存并部署。

7.点击部署中的域名链接访问站点,如果有内容出现,就证明部署成功了。

8.查看节点信息地址: https://域名链接/UUID

9.(可选项)如果有在 Cloudflare 中有域名托管,也可以在自定义域中设置自定义域。

问题:

login Ubuntu 显示 There is 1 zombie process.

解决:

ps axo stat,ppid,pid,comm | grep -w defunct

sudo kill -9 <ppid>

20年的微软 VScode 用户,在 Windows 一直很方便,在 Macbook 上,要使用 cquery 插件,但是作者停止更新超过五年了,连 GitHub 上的仓库都关了,没了 repo,Apple Silicon 编译不了 cquery。

解决方法是使用 cquery 的一个个人开发的分支 ccls,现在有了一个更加稳定的官方项目,llvm 官方团队的 clangd,基于 Clang C++ Compiler,默认集成到了 llvm 项目中,安装 llvm 后即可使用。

1.安装 llvm。

$ brew install llvm

2.打开 VScode,搜索"clangd"安装 clangd 插件。

3.关闭 VScode 中 C/C++ 插件的智能提示功能。

"C_Cpp.intelliSenseEngine": "Disabled",

4.为工程生成 compile_commands.json 文件,clangd 需要它来分析依赖关系。

使用 CMake 编译时,需要添加参数

$ cmake .. -DCMAKE_EXPORT_COMPILE_COMMANDS=YES

或在 CMakeLists.txt 里,指定生成

set(CMAKE_EXPORT_COMPILE_COMMANDS YES)

生成的 compile_commands.json 文件可能在 build 目录下,这时需要在项目主目录里创建一个该文件的软链

ln -s build/compile_commands.json .

重启 vscode,或者 CMD+Shift+P 输入 Reload Window

Meta 的 Llama3 大语言模型开源以后,Ollama做了整合3B版本,可以很方便的部署使用,7B就算了,实在用不起。

0x00 硬件要求

GPU 最好使用 NVIDIA RTX4060 以上级别的显卡,响应速度流畅。

CPU Intel 12代以上,纯 CPU 模式响应度很慢。

0x01 官方支持

https://ollama.com/

https://hub.docker.com/r/ollama/ollama

0x11 部署服务

CPU 模式

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

GPU 模式

Nvidia GPU 需安装 NVIDIA Container Toolkit:

curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey \

| sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg

curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list \

| sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' \

| sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list

sudo apt-get update

安装 NVIDIA Container Toolkit packages:

sudo apt-get install -y nvidia-container-toolkit

Yum 或 Dnf 安装:

curl -s -L https://nvidia.github.io/libnvidia-container/stable/rpm/nvidia-container-toolkit.repo \

| sudo tee /etc/yum.repos.d/nvidia-container-toolkit.repo

安装 NVIDIA Container Toolkit packages:

sudo yum install -y nvidia-container-toolkit

配置 Docker 使用 Nvidia driver:

sudo nvidia-ctk runtime configure --runtime=docker

sudo systemctl restart docker

启动容器:

docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

AMD GPU 安装:

docker run -d --device /dev/kfd --device /dev/dri -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama:rocm

0x12 安装 API

docker exec -it ollama ollama run llama3

0x13 部署 WEB UI

CPU 模式:

docker run -d -p 8090:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

GPU 模式:

docker run -d -p 8090:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

0x14 登录 WEB

http://IP:8090